In der aufregenden Welt der Künstlichen Intelligenz (KI) haben sich Sprachmodelle wie ChatGPT, Bard und Claude schon als äußerst nützlich erwiesen. Sie generieren Texte von simplen Frage-Antwort-Aufgaben, lösen Programmieraufgaben und können akademische Texte erstellen. Allerdings entsteht eine Herausforderung, wenn es um die Zuordnung der Autorenschaft geht, insbesondere im akademischen Umfeld.

Bisherige Plagiatserkennungssysteme scheitern an der KI

In dieser Hinsicht stellt sich die Frage der Authentizität von Texten, die mithilfe von KI generiert wurden. Insbesondere in der akademischen Welt besteht die Gefahr, dass der Einsatz von KI-Generatoren das Lernen von Studierenden beeinträchtigt oder Forschungsergebnisse durch automatisch generierte Ableitungen beeinflusst. Gegenwärtige Plagiaterkennungssysteme können zwar die Quelle eines eingereichten Textes zurückverfolgen, sind jedoch noch nicht in der Lage, KI-generierten Text zuverlässig zu erkennen.

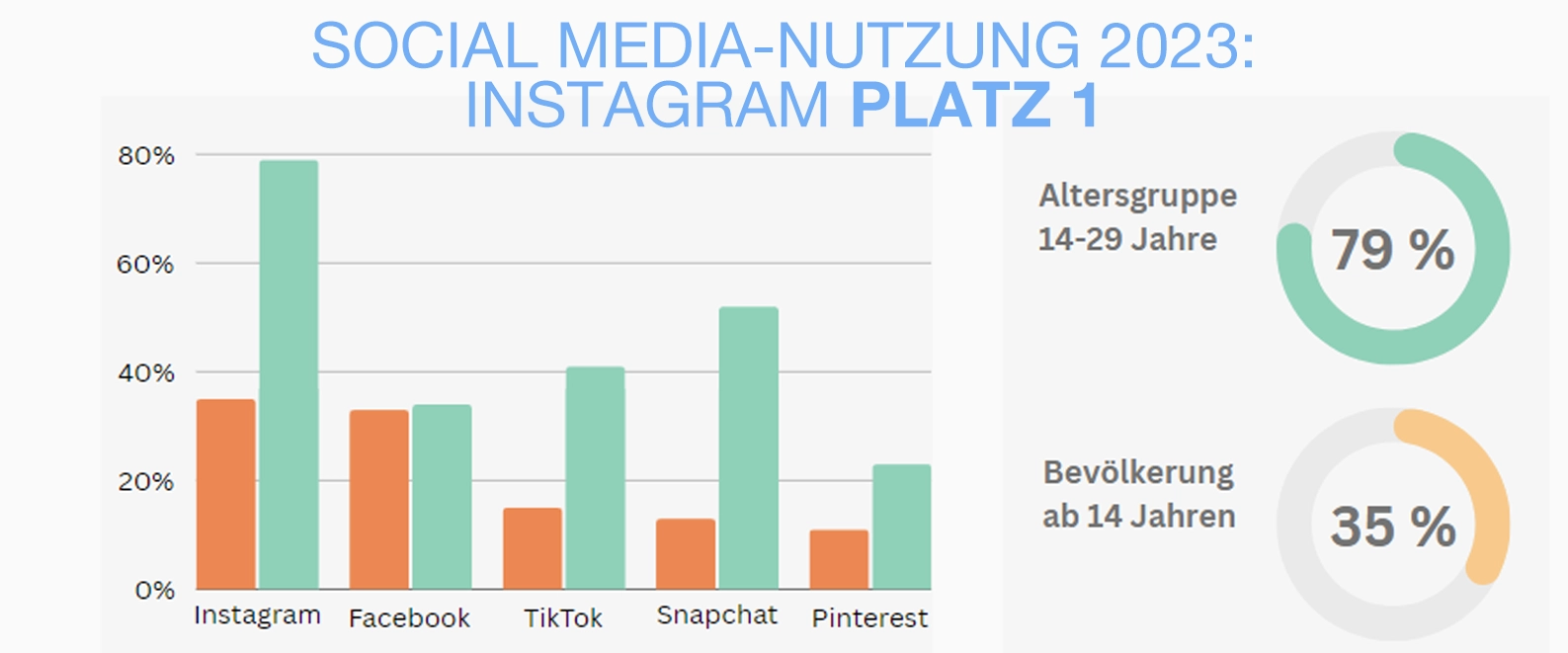

Die beliebtesten Plattformen

Die Autoren der wissenschaftlichen Studie erläutern die Idee einer direkten Herkunftserkennung durch KI-Sprachmodelle ihre eigenen Inhalte erkennen können. Anhand einer kleinen empirischen Studie mit dem Ansatz des "Zero-Shot Learning" untersuchen Sie die Fähigkeit von Modellen wie Google's Bard, OpenAI's ChatGPT und Anthropic's Claude, ihren eigenen Text zu erkennen.

KI-Sprachmodelle können Ihre eigene Arbeit nicht immer erkennen

Die Ergebnisse zeigen unterschiedliche Fähigkeiten der KI-Systeme, ihren generierten Text zu identifizieren. Bard von Google zeigt die höchste Fähigkeit zur Selbstidentifikation mit einer Genauigkeit von 94%, gefolgt von ChatGPT von OpenAI mit 83%. Im Gegensatz dazu scheint Claude von Anthropic nicht in der Lage zu sein, sich selbst zu erkennen.

Beispiel 1: Probleme in der Forschung

Stellen wir uns vor, ein Student verwendet ein KI-Modell, um eine wissenschaftliche Arbeit zu verfassen. Die generierten Inhalte könnten so geschickt verfasst sein, dass sie den Eindruck erwecken, von einem versierten Forscher geschrieben zu sein. Wenn solche Arbeiten ohne klare Kennzeichnung als KI-generiert eingereicht werden, könnte dies zu ethischen Bedenken bezüglich der Urheberschaft und akademischen Integrität führen. Universitäten und Forschungseinrichtungen stehen vor der Herausforderung, den Einsatz von KI in der Bildung ethisch zu regeln.

Beispiel 2: Verbreitung von Fake News

Ein Nachrichtenportal verwendet KI, um automatisch Nachrichtenartikel zu generieren. Die von der KI erstellten Artikel könnten den Eindruck erwecken, dass sie von menschlichen Journalisten verfasst wurden. In diesem Kontext könnte die Authentizität der Berichterstattung in Frage gestellt werden, da Leser möglicherweise nicht zwischen von Menschen erstellten und KI-generierten Inhalten unterscheiden können. Dies könnte Auswirkungen auf die Glaubwürdigkeit von Nachrichtenmedien haben.

Beispiel 3: Rechtliche Dokumente und Verträge

Eine Anwaltskanzlei setzt KI-Modelle ein, um rechtliche Dokumente und Verträge zu generieren. Die automatisch erstellten Vertragsklauseln und juristischen Texte könnten so präzise formuliert sein, dass sie kaum von den von Anwälten verfassten Dokumenten zu unterscheiden sind. Dies könnte zu rechtlichen Komplikationen führen, insbesondere wenn die Gegenpartei annimmt, dass menschliche Anwälte die Dokumente verfasst haben. Die Authentizität und Transparenz solcher Rechtsdokumente werden somit zu kritischen Anliegen.

Fazit: KI muss erkennbar sein

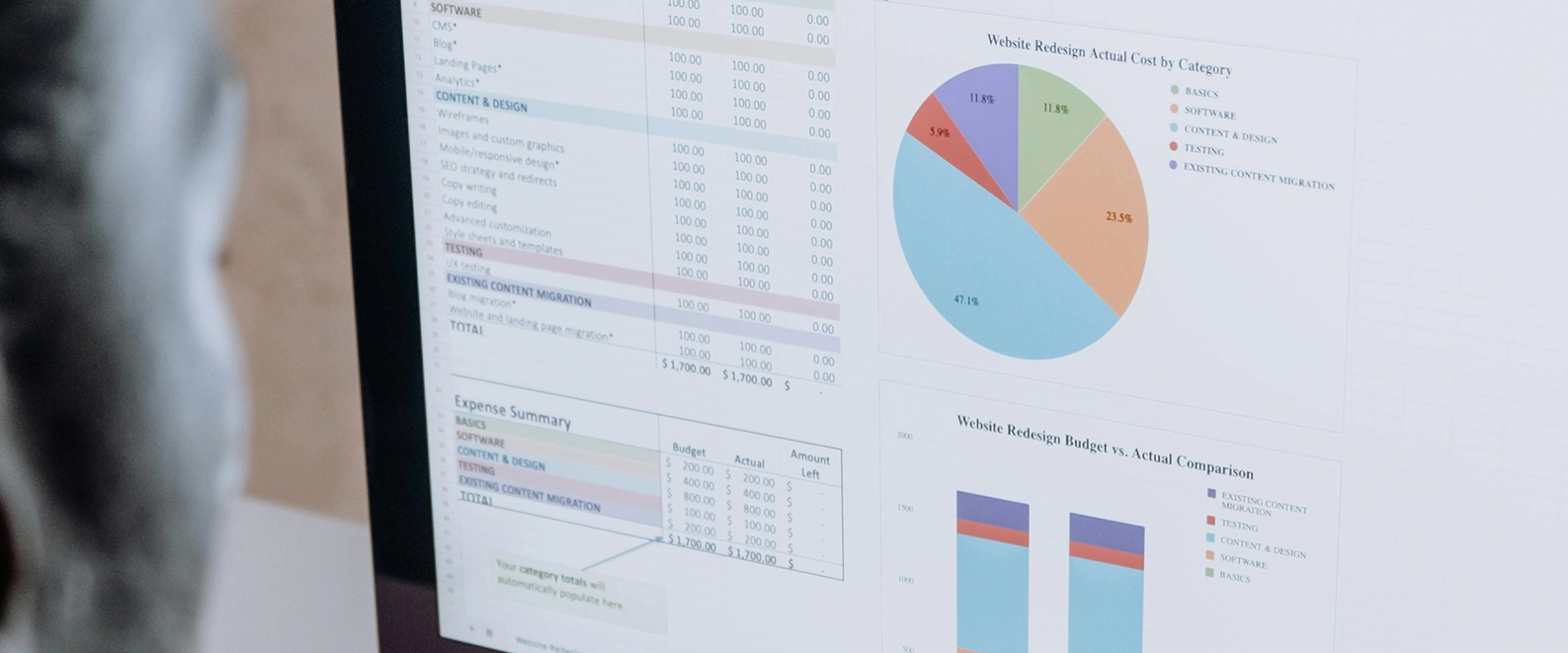

Die Erkennung von KI-generierten Inhalten wird zu einer immer wichtigeren Herausforderung. Die Ergebnisse dieser Studie unterstreichen die Notwendigkeit einer Überprüfung von Plagiatsdefinitionen und der Entwicklung robusterer Techniken zur Identifizierung von KI-generierten Inhalten. Wir stehen vor der Herausforderung, den Einsatz von KI in Bildung und Forschung ethisch zu gestalten und gleichzeitig ihre positiven Potenziale zu nutzen.

Quelle:

University of Dallas, 28.12.2023, AI Content Self-Detection for Transformer-based Large Language Models

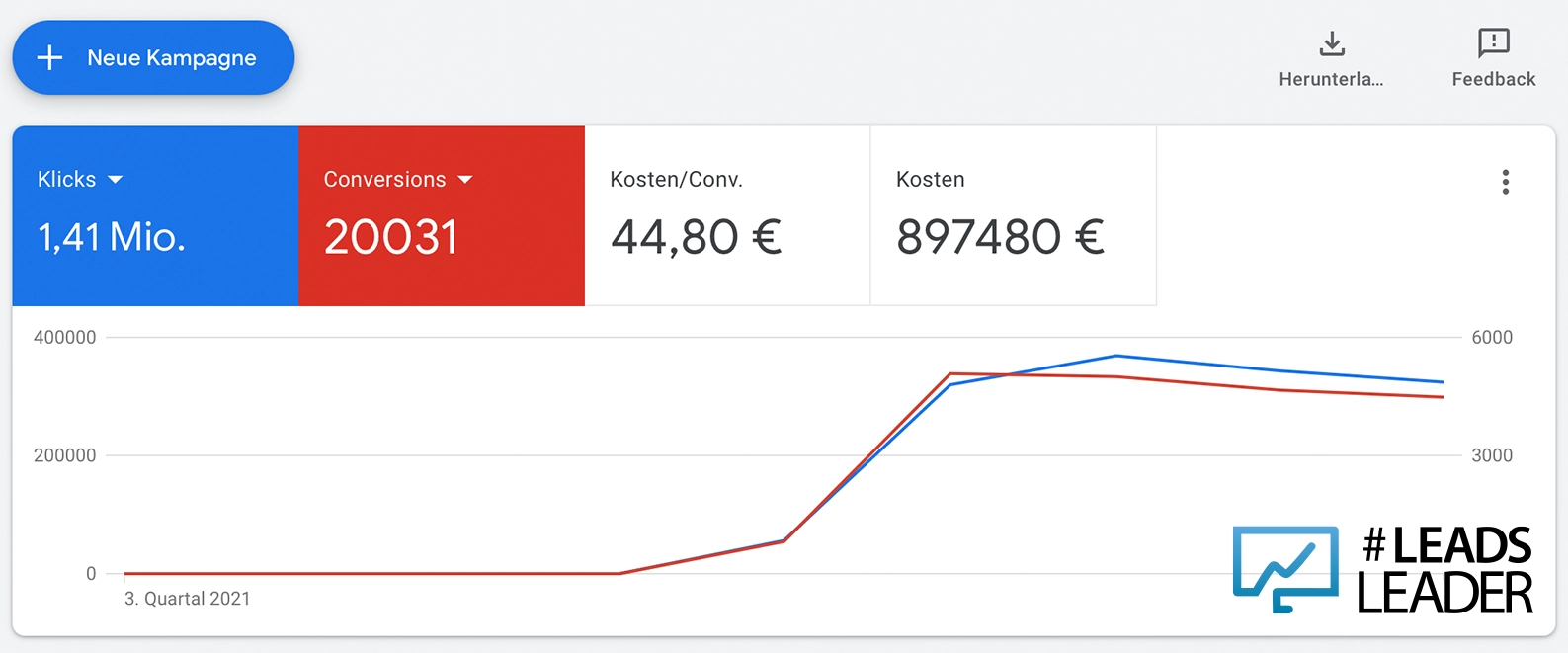

Leadsleader ist eine spezialisierte Online-Marketing Agentur in den Bereichen SEO, SEO Beratung und Google Ads. Wir steigern die Sichtbarkeit Ihrer Website und reduzieren Ihre Google Ads Kosten. Zusätzlich bieten wir praxisnahe Live-Webinare an.

von

von